やばい、4月が終わってしまう!(^_^;)…ということで、1ヶ月ぶりの更新です…。えーっと、前回は何を書いたんだっけ?状態です…。

前回はSCVMMによって管理されるまさに論理的なスイッチである「論理スイッチ」について見てきましたが、今回は「ネットワークプロファイル」と「ポート分類」について見て行きたいと思います。

まずネットワークプロファイルですが…話が脱線するかもしれませんが、SCVMMの機能ではあるものの、このネットワークプロファイルというが概念はとてもCisco的な思想が色濃く反映されているように私には思えます。SCVMMに対してNexus 1000V for Microsoft Hyper-Vを実装するためには、SCVMM側がそれに対応した仕様になっている必要があり、その最大のポイントともいえる機能が、この対象スイッチとは分離されて管理されるポートプロファイル機能だと言えるからです。

さて、ではポートプロファイルとは何なのか。簡単にいえば、ポートプロファイルは設定対象とは分離して管理されているパラメータ情報、です。

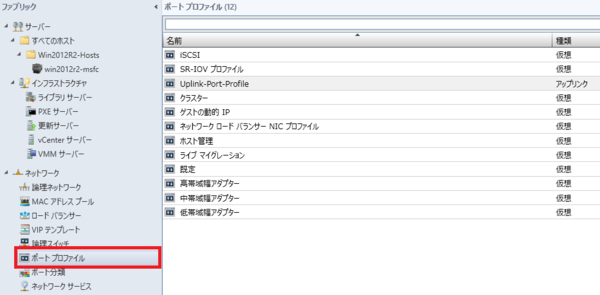

この画面は、SCVMM2012R2のポートプロファイル画面です。一般的によく使われるであろうことが想定される項目については、デフォルトで用意されています。また、高帯域/中帯域/低帯域など、ポートプロファイルを使ってどのような分類を行えばよいのかについて参考になるのではないかと思います。

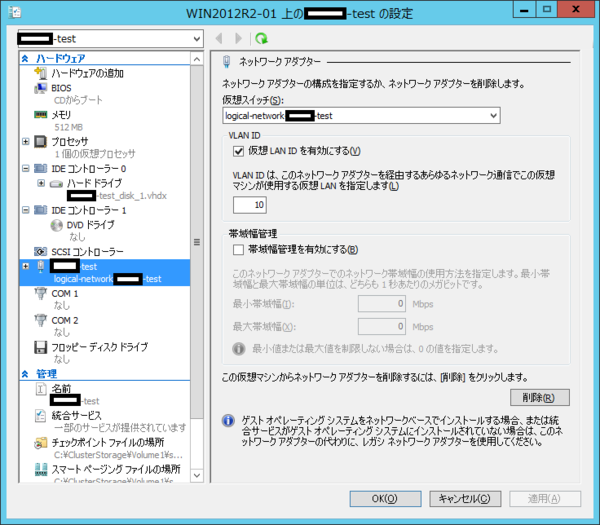

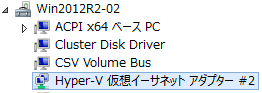

ポートプロファイルには、種類として「アップリンク」と「仮想」があります。前回のエントリーで見たように、論理スイッチにおいて、アップリンクにはアップリンクポートプロファイルが直接的に、仮想マシンが接続する側の仮想ポートについては、ポート分類に対して紐付けられたパラメータとして仮想ポートプロファイルがリンクされます。つまり、ポートプロファイルにおいて定義した構成は、論理スイッチにおいて実際の設定対象と紐付けられることになります(厳密には、論理スイッチはさらに各Hyper-Vホストにおいて物理アダプターに紐付けられるわけで、抽象化が階層化されているわけですが)。

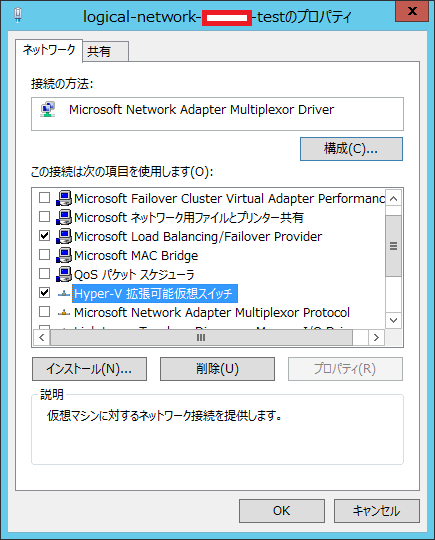

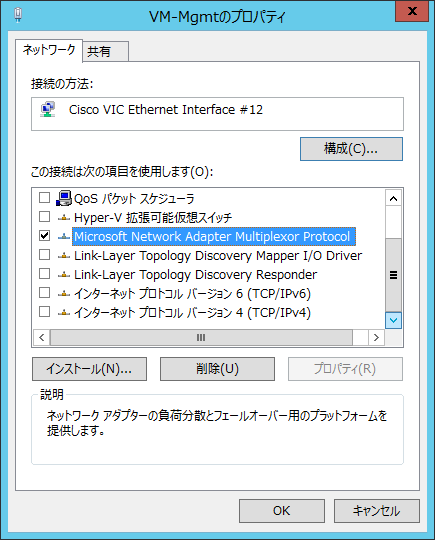

ポートプロファイルにおいて、アップリンクポートプロファイルと仮想ポートプロファイルでは異なるプロパティを持ちます。

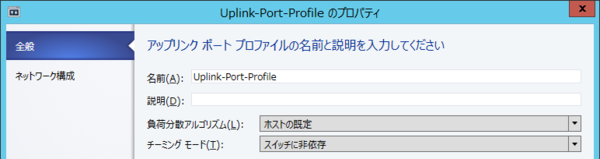

<アップリンクポートプロファイル>

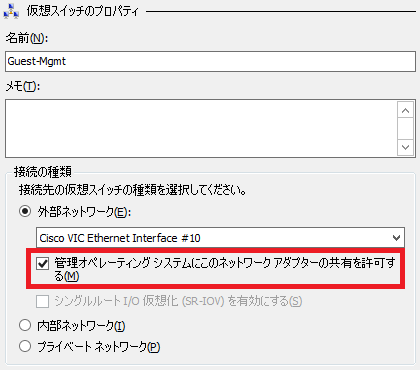

なんといってもアップリンクポートプロファイルの特徴は、上図のようにアップリンクポートに対する定義パラメータを持つことです。アップリンクポートとしてインターフェイスにおける負荷分散アルゴリズムと、チーミングモードを定義することができます。Windowsホストとして持つチーミング定義と、SCVMMにおけるアップリンクポートプロファイルとして構成するチーミング定義が併存していることも、ちょっとSCVMMによって管理されるHyper-V環境をわかりづらくしている要因の1つといえるかもしれません。

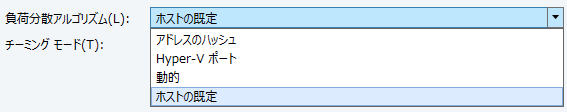

負荷分散アルゴリズムとしては、以下の選択肢から選ぶことができます。

- ホストの既定

- アドレスのハッシュ

- Hyper-Vポート

- 動的

-

- 「ホストの既定」は、特にSCVMMから指定を定義しない選択肢です。設定は、各ホスト毎に定義を行う必要があります。

- 「アドレスのハッシュ」は、送信先・送信元のMACアドレスやIPアドレス、ポート番号などを元にハッシュ計算した結果に基づいてアップリンクポートが選択される負荷分散アルゴリズムです。ハッシュ計算に使用されるヘッダ情報の組み合わせについては、プロトコル種別などによって異なり、どの組み合わせを優先的に使用するかについてはPowerShellを使って定義を変更することも可能です(…が、あまり変更することは推奨されませんが)。

- 「Hyper-Vポート」は、Hyper-Vのアップリンクポートとして使用する場合のみ使用することができる負荷分散アルゴリズムです。仮想ポート毎に指定されているポートIDに基づいて、使用するアップリンクポートが選択されます。そのため、ある仮想マシンは当該アップリンクポートがダウンしない限り、ずっと特定のアップリンクポートのみを使用し続けます。つまり、仮想マシン毎に見ると負荷分散はされていなくても、仮想スイッチ全体としては負荷分散されていることになる方式といえます。

- 「動的」は、単純にチーミングを構成する各アダプターの負荷状況に基づいて使用する経路を動的に変更する負荷分散アルゴリズムです。これはWindows Server 2012R2から実装された新方式ですが、ハッシュ計算などの負荷が小さいため、2012R2では既定の負荷分散アルゴリズムとなっています。

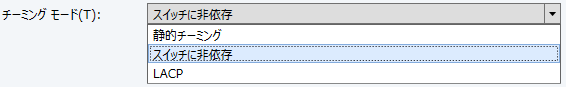

チーミングモードとしては、以下の選択肢から選ぶことができます。

- 静的チーミング

- スイッチに非依存

- LACP

-

- 「静的チーミング」は、ホストから見て対向の接続先は1台と認識されるスイッチ(物理的に1台のスイッチ、スタック構成のスイッチ、vPCなどの論理的に1台のスイッチとして認識できる論理スイッチ)と接続する必要のあるチーミングモードです。

- 「スイッチに非依存」は、チーミングの構成ポートが異なるスイッチに接続することが可能なチーミングモードです。負荷分散アルゴリズム次第で、各アップリンクポートがActive/Activeとなるか、Active/Standbyとなるかが決まります。

- 「LACP」は、対向のスイッチでLACPを構成・使用できるチーミングモードです。LACPが構成されていれば、スタック構成やvPCなどの対向からは論理的に1台と認識される構成などで使用することができます。

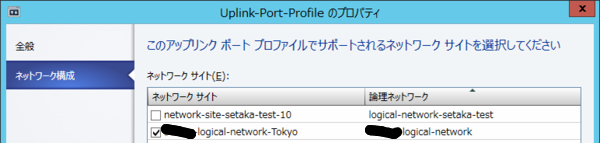

アップリンクポートは、Hyper-Vホストの物理構成を意識してポートプロファイルを定義する必要があるため、対象とするネットワークサイトを指定することができます。

あー…思わず細かく書き出してしまったら、ここまでですでにだいぶ長くなってきてしまったので、アップリンクポートプロファイルだけで一区切りさせていただきます。

次回は仮想ポートプロファイルに続きます…。

![Software Design (ソフトウェア デザイン) 2014年 01月号 [雑誌] Software Design (ソフトウェア デザイン) 2014年 01月号 [雑誌]](https://images-fe.ssl-images-amazon.com/images/I/51x-%2B%2BP4A-L._SL160_.jpg)